Um dos grandes pilares do método científico é a replicabilidade dos experimentos. Gosto muito do exemplo de um professor de história: a lei da gravitação dos corpos pode ser verificada em qualquer lugar. Nem mesmo o Papa (com todo seu poder inclusive político na Idade Média) pode rezar or ordenar que um objeto não seja atraído pela Terra. Isto vale para atualidade: todo artigo científico, para ser aceito, deve ser possível de ser replicado por outros cientistas.

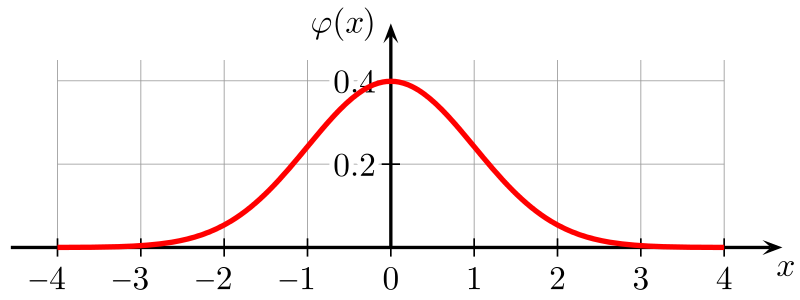

Boa parte dos artigos reportam fenômenos analisados estatisticamente e as conclusões são feitas baseadas em um indicador de incerteza, conhecido como p-valor. A incerteza decorre de os modelo estatísticos não conseguirem explicar com 100% de certeza o fenômeno que está sendo modelado. Por exemplo, poderíamos coletar variáveis de dezenas de países como escolaridade média, reserva estimada de ferro e petróleo, comprimento do litoral e tentar correlacionar com o PIB per Capita do País. O resultado seria uma equação em que, a partir destas variáveis (escolaridade média, etc), poderíamos obter o valor do PIB de cada país. Sabemos que a partir dessas variáveis poderíamos até ter uma estimativa do PIB de cada país, mas dificilmente a relação valeria exatamente para todos os países. Afinal, seria difícil que algo tão complexo como a produção possa ser explicado perfeitamente por 5 ou 10 variáveis sem que haja erros. No entanto, existem ferramentas estatísticas que podem dar uma base do quão certos estamos do resultado e tirar conclusões úteis em cima disso.

Várias conclusões muito importantes são obtidas com esse tipo de estudo. Um exemplo que está na boca do povo é o efeito de saneamento básico nos gastos com saúde. Por mais que os dados não consigam predizer exatamente os gastos futuros com saúde, temos um bom nível de certeza desta relação.

Por ser extremamente prática e útil, uma enorme quantidade de artigos científicos se baseia em métodos científicos para analisar resultados de dados obtidos. Porém, em anos recentes, começou a se observar que em muitos deles os resultados não são os mesmos quando outros grupos de pesquisa realizam exatamente o mesmo experimento. Isso abriu uma série de discussões de como muitos pesquisadores estão “hackeando” seus resultados. Uma ótima descrição do assunto pode ser visto neste texto aqui do Deviante do William Magalhães. Em meio a essa discussão, ganharam notoriedade os “estudos de replicação”. Em vez de pesquisadores tentarem achar novas pequenas descobertas, recursos estão sendo despendidos “apenas” para confirmar resultados anteriores. Isto pode parecer óbvio, mas não é tanto já que em geral pesquisadores conseguem verbas para fazer novas descobertas e não confirmar descobertas anteriores. Se um autor tentar simplesmente replicar os resultados de um estudo anterior, este artigo poderia muito bem ser rejeitado por não ter novidade científica. Principalmente se o resultado for parecido com o estudo anterior.

Recentemente um grupo de pesquisadores recebeu recursos para replicar uma série de estudos recentes com objetivo de analisar a replicabilidade na área de ciências sociais. Os estudos escolhidos para serem replicados são publicações de 2010 até 2015 das revistas Science e Nature, talvez as duas publicações mais renomadas internacionalmente no meio científico. Portanto todos os estudos passaram pelo crivo da revisão por pares. Isto é, outros cientistas da área anonimamente apresentaram comentários sobre estes experimentos e concordaram que eram estudos com padrões elevados o suficiente para serem publicados.

O resultado pode ser visto graficamente na Figura abaixo. Quanto mais à direita um ponto está significa que maior é a certeza que a hipótese foi validada e que o estudo foi replicado com sucesso. No total, 13 dos 21 estudos foram replicados e portanto 8 destes estudos chegaram em conclusões opostas.

Nestes estudos dois aspectos são amplamente discutidos: se a hipótese testada é estatisticamente significativa (não é bem isso mas uma simplificação seria a certeza que uma variável tem determinado “sinal” correto) e suas magnitudes. Por exemplo, podemos fazer um estudo com a população brasileira inteira e verificar, por exemplo, se o tamanho da mão está associado a um salário maior. Possivelmente achar que cada centímetro de mão aumenta o salário mensal por R$0.02 com uma incerteza baixa. Por exemplo temos 99,9% de certeza que o aumento está entre R$0.0199 e R$0.2001. Neste caso poderíamos afirmar com certeza que ter uma mão maior está relacionado a salários maiores (ou seja, o “sinal” é positivo: “quanto maior a mão maior o salário”), mas a magnitude deste aumento é extremamente pequena. Não valeria a pena passar por uma cirurgia para aumentar a mão em 2cm e ganhar 40 centavos a mais por mês. Por outro lado, se nossa confiança estivesse no intervalo [R$-0.02, R$300.00] significaria que não teríamos certeza se o tamanho da mão aumenta o salário (afinal, ele pode ser negativo no intervalo acima). No entanto os dados sugerem que a magnitude é maior neste caso e a média das expectativas é em torno de R$150,00. O gráfico acima diz mais respeito ao primeiro aspecto, o “sinal”.

Nos 13 estudos que conseguiram ser replicado pelo primeiro aspecto, mais dados foram obtidos com objetivo de mensurar com mais exatidão as magnitudes (isto é, a mão maior aumenta o salário mas aumenta quanto?). Comparado com os originais, o valor das magnitudes foram 25% menores em média. Por exemplo, se um estudo anterior havia chegado a conclusão que cada centímetro de mão adiciona R$100,00 no salário, a média dos resultados diz que na verdade seriam R$75,00. Não é muito menor, porém o resultado esperado seria na média o mesmo dos estudos originais.

No entanto um fato chamou atenção para este estudo. Antes de realizar os experimentos, os pesquisadores fizeram uma enquete com 206 pessoas da área para eles votarem nas chances de cada estudo ser replicado. De acordo com a enquete 63,4% dos estudos seriam replicados com sucesso que é um número muito próximo dos 61,9% que foi atingido. Eles também criaram um sistema parecido com “aposta” para as mesmas pessoas que responderem a enquete de “apostar” em um sistema análogo a uma bolsa de valores. Os resultados são parecidos utilizando as duas metodologias como pode ser visto na Figura abaixo. O eixo y representa cada estudo ordenado sendo que o primeiro é o estudo com maior certeza que foi replicado com sucesso e o último sendo o extremo oposto (com certeza não replicado). O eixo x é a expectativa dos pesquisadores de que cada estudo seria replicado com sucesso. O gráfico mostra que de fato os pesquisadores, coletivamente, conseguiram prever nos resultados da replicação.

Talvez seja essa a ótima notícia do experimento. Por mais que diversos estudos não consigam ser replicados – e isto significa que uma hipótese em que se acreditava ser verdadeira não é- um grupo de especialistas da área consegue ter uma ideia da certeza destes resultados. Possivelmente pode-se utilizar estas enquetes para identificar estudos com potencial de não ser replicado mais eficientemente. Um dos autores também colocou na conta do Twitter que os resultados foram discutidos com os autores originais e os autores originais e estão discutindo como refinar as hipóteses e os experimentos. Esse diálogo é literalmente ciência!

Referências

Texto do William Magalhães –

Versão inicial do estudo apresentado.

Thread no twitter em que um dos autores apresentaram resumidamente os estudos e alguns comentários.