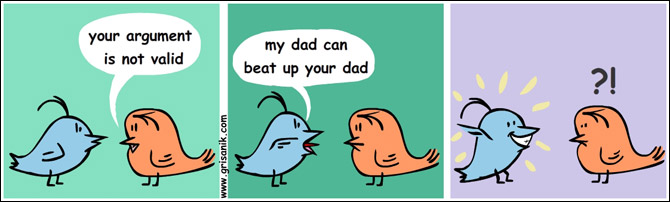

Provavelmente você já ouviu em algum lugar o título desse texto. O grau de autoridade que a ciência tem hoje, e por sua vez muitos cientistas, acaba fomentando o uso inadequado e falacioso da ciência, assim como de estudos científicos. Falacioso pois um “a ciência diz que tal intervenção (um tratamento ou uma política pública, por exemplo) não tem efeito [e acabou]” ou “Um cientista disse que tal intervenção (um tratamento ou uma política pública, por exemplo) não tem efeito [e acabou]” é um apelo à autoridade, também conhecido como argumentum ad verecundiam ou argumentum magister dixit. E inadequado porque ou não é exatamente isso que as pessoas querem dizer, ou, se é, elas não sabem do que estão falando. Ao longo desse texto, irei descrever o que se passa por trás das cortinas nesses dois casos.

Pirâmide de evidência [científica]

O que é uma pirâmide de evidência, e por que ela existe? Trago o trecho abaixo para responder essa pergunta. Achei bem didático e foi retirado do blog Seja PhD.

Os níveis de evidência (também chamados de pirâmide de evidência) foram descritos pela primeira vez em 1979 no Canadá. Uma pirâmide de evidência é construída por estudos com base na qualidade da metodologia ou do desenho experimental, validade e aplicabilidade ao atendimento ao paciente. Nessa pirâmide, são classificados os tipos de estudo, de acordo com a evidência clínica e científica que eles possuem. Essas decisões dão o “grau (ou força) da recomendação”. Por isso nas diretrizes terapêuticas para hipertensão, por exemplo, fala sobre os diferentes graus de recomendação 1, 2 ou 3, ou seja, o nível 1 é o maior, isso significa que aquela informação é consensual entre os médicos. A classificação dos níveis de evidência foi motivada pela necessidade de usar o conhecimento científico como suporte na prática clínica, pois devido ao grande número de publicações, não é qualquer estudo que pode ser usado para basear uma decisão clínica. Por isso, os estudos são classificados quanto ao tipo e a qualidade.

Arrisco dizer que nessa altura da pandemia, você já deve ter visto alguma representação dessa pirâmide. Abaixo, você verá um exemplo.

A “força” da evidência cresce de baixo para cima e, de certo modo, podemos entender isso como estudos que vão abrangendo mais e mais da realidade, principalmente quando chegamos em revisões sistemática / meta-análises que levam em consideração estudos em cenários diferentes. Se estamos falando de uma droga para inibir a replicação de um vírus, podemos ter pesquisas iniciais em uma cultura de células, no laboratório. Posteriormente, isso pode ser avaliado em um organismo vivo. Posteriormente, organismos mais similares a nós, seres humanos. Posteriormente em um número reduzido de indivíduos da nossa espécie. Posteriormente em uma coorte maior. Eventualmente em grupos mais diversos, de outros países ou com características variadas. Com resultados positivos sucessivos, podemos chegar a ensaios clínicos randomizados, com placebo, duplo-cego (e a lista de características segue). Não sabe o que é isso? Expliquei aqui em áudio e aqui em texto! Vale a pena ler (ou ouvir), já que as características que esses estudos possuem nos permitem chegar a conclusões que outras metodologias não permitem, em contraste por exemplo com evidências anedóticas (Tomei coca-cola com limão todo dia e fiquei melhor, portanto…).

Um detalhe é que não necessariamente as investigações sobre o tema seguem esse passo a passo, embora seja comum. Ficou implícito aqui que esse avanço nos tipos de estudos ocorre devido a resultados positivos nos “estágios” anteriores. Utilizando a estratégia tal, conseguimos inibir replicação viral em cultura celular? Show! Vamos para um organismo modelo. Conseguimos de novo? E assim por diante. Mas… e se não encontramos resultado positivo? Paramos por aí? Um resultado negativo significa que essa intervenção não tem efeito? Em um linguajar mais informal, quer dizer que não funciona? Ninguém mais deve estudar isso?

Eu abri uma enquete no Twitter com o seguinte questionamento:

Uma pergunta para os colegas que tem algum treinamento científico (seja pós-graduação stricto sensu ou experiências como Iniciação Científica). Em um estudo, temos na conclusão: “Nossos experimentos não foram capazes de identificar qualquer efeito de A em B”. Poderia também ser “Não encontramos correlação entre A e B”. Digamos que o estudo esteja bem feito. Isso significa que:

A) A não funciona.

B) A não funciona em B.

C) Autor não encontrou efeito.

D) A não pode curar B.

Pense um pouco. Qual a resposta correta na sua opinião? O resultado está ao fim desse texto. É importante frisar que, ainda que eu tenha pedido apenas para pessoas com treinamento científico responderem essa enquete, nada impede que outras pessoas tenham respondido. É uma limitação desse tipo de enquete, e que apenas se soma a várias outras limitações (como viés de seleção da minha bolha do Twitter).

Um dos conceitos mais básicos da pesquisa científica é o de que correlação não implica causalidade. Eu falei sobre isso em um Spin de Notícias recente com o título “O que é Viés de Colisão e qual sua influência em estudos sobre a COVID-19?”, e de forma mais introdutória no texto “Papo casual: Correlação não é a mesma coisa que causalidade” na Revista Kratos. No entanto, algo menos conhecido é que causalidade também não implica correlação. Se você tem algum treinamento científico, é possível que você tenha pensado: “Hm.. Correlação linear, de Pearson, certo? Existem algumas associações que apenas podemos identificar com coeficientes capazes de capturar relações não lineares”. E… Não. É possível que, para um determinado conjunto de dados, você não seja capaz de identificar qualquer tipo de correlação entre duas variáveis, ainda que uma seja causa direta da outra. Embora na “vida real” exista uma associação, nós não trabalhamos com a realidade, mas com uma abstração dela. Ás vezes essa abstração é muito próxima da realidade, às vezes não e, infelizmente, nem sempre é trivial identificar quão próximo estamos dela.

Para o texto não ficar muito massante e técnico, vou trazer uma história contada pelo Ramón, também colaborador aqui do portal. O cidadão liga para a assistência técnica de seu carro e conta a seguinte história pitoresca:

– Sempre que vou tomar sorvete de creme na sorveteria, meu carro tem dificuldade de ligar quando vou embora. O curioso é que se eu escolho qualquer outro sabor, o carro funciona normal. Já tentei vários sabores e o carro sempre liga normal, mas se eu escolho o bendito creme… Tenho dificuldade em fazer o carro ligar após receber o pedido. O carro não gosta de sorvete de creme?

Após investigação, os técnicos descobriram que havia uma peça do carro superaquecendo. O sorvete de creme é o que mais saía, tinha um fluxo diferente dos outros sabores, ficava pronto rápido. Quase que imediatamente se recebia o sorvete após pagar, e a peça ainda estava quente. Desse modo, o carro não ligava. Os outros sabores demoravam mais para sair e era o tempo necessário para a peça esfriar.

É um exemplo bobo, mas é bobo porque sabemos que as chances do sabor de um sorvete interferir na mecânica do carro é desprezível. No entanto, existem cenários onde não temos tanto conhecimento sobre o fenômeno estudado e, por essa e outras razões, se torna muito mais complicado discutir sobre questões de causa e efeito. Voltando para estudos científicos, se o seu estudo não identificou efeito de uma determinada intervenção, o que você pode dizer? Exatamente isso. Os autores não foram capazes de identificar efeito a partir dessa intervenção com a metodologia descrita aqui no estudo. Se vários autores reproduzirem o seu estudo, com populações diferentes, mesma metodologia, metodologias parecidas ou diferentes, e ainda assim não conseguirem identificar efeito, o grau de evidência desses resultados se fortalece. Eventualmente, alguém pode fazer uma revisão sistemática ou meta-análise desses estudos e tentar delinear algum consenso sobre o assunto.

Uma pergunta interessante que pode estar te rondando nesse momento é: Então eu nunca posso dizer que não existe efeito a partir de uma intervenção? Tecnicamente, é exatamente isso. Com o conhecimento científico que temos hoje, não é possível dizer que não existe efeito entre dois eventos. Exceções a isso são quando utilizamos pressupostos não verificáveis. Exemplo? Decidimos que o futuro não pode afetar o passado. Desse modo, a chuva de amanhã não pode ter tido efeito sobre o deslize de terra que aconteceu mês passado (podem ter até uma causa em comum, o que nos permitiria fazer predições, mas a chuva do futuro não tem como ter causado o deslize que ocorreu no passado).

Imagino que os pontos que trouxe até agora, principalmente nos demais materiais de minha autoria que linkei ao longo desse texto, tenham deixado claro por que dizer “a ciência diz que não tem efeito de A em B” indica que o autor da declaração pode não saber do que está falando. No entanto, eu também trouxe uma outra alternativa! A de que não é exatamente isso que as pessoas querem dizer, e o dizem, por exemplo, talvez por acharem que é mais didático ou suficiente para passar a mensagem. Nesse caso, uma possibilidade do que as pessoas querem dizer na verdade é: [Com base nos estudos que foram feitos até agora, as chances de existir um efeito de A em B é pequena e, se ocorrer, é um efeito tão pequeno que se torna desprezível. Com base nisso, portanto, digo que] A não tem efeito em B, em outras palvras, A não funciona [em B]. Embora eu compreenda que não é nada apetitoso para leigos ouvir tudo isso, a minha posição é de que é mais responsável (e sadio para a ciência no longo prazo) afirmar que não foi possível identificar efeito de A em B com a metodologia adotada. Fiquei contente em ver que a maior parte das pessoas marcou a resposta correta.

Uma história que me veio a mente enquanto escrevia esse texto é do episódio em que o Neil deGrasse Tyson se referiu a várias notícias que em algum trecho dizem “Cientistas agora precisam voltar para a lousa”, ou voltar para a bancada, quando na verdade cientistas nunca saem de lá. O tempo todo estamos buscando hipóteses que nos parecem interessantes e estudando-as. Nessa temática, chegamos em um tema espinhoso: Cientistas devem ser livres para estudar as hipóteses que quiserem? Acompanhei, por exemplo, algumas discussões sobre cientistas que seguem realizando estudos para tentar verificar efeito de alguns possíveis tratamentos para COVID-19 cuja eficácia já foi estudada anteriormente e, em vários estudos, nenhum efeito foi encontrado. Isso deveria ser permitido? Na minha opinião, em um mundo onde recursos são limitados, seja pessoal ou de custeio para infraestrutura, entre outras coisas, eu preferiria que focássemos em hipóteses com mais chances de estarem corretas. No entanto, se algum cientista quer dedicar o seu tempo, e os recursos que tem para isso, para estudar uma hipótese improvável, Bonne chance!

Toda vez que vejo mais um estudo sobre um assunto, confirmando os resultados anteriores, ao menos em um momento inicial isso me reconforta por estarmos conseguindo diminuir a incerteza dos resultados anteriores. Afinal, é isso que a ciência nos permite fazer. Diminuir nossa incerteza sobre afirmações acerca do universo. E se os resultados contestam os resultados anteriores, uma revolução na ciência pode estar prestes a acontecer, como já aconteceu no passado. Mais estudos são necessários. Um grande detalhe aqui, claro, é que estou levando em consideração (1) a pirâmide de evidências e (2) estudos bem elaborados. Resultados confirmados inúmeras vezes não vão ser facilmente abalados por um estudo com limitações severas em cultura celular, compreende?

Um outro perigo é o significado que se dá à ciência. Em alguns casos, a ciência parece ser essa entidade que não erra e que, ainda por cima, é um nome bonito para se esconder um estudo mal elaborado por trás. Vou dar um exemplo para ficar mais claro. “Você está errado, porque a ciência diz que isso não é assim!” Nesse caso hipotético, quem é a ciência que o interlocutor se refere? Um estudo mal feito, que não foi revisado por pares e escrito por autores que não entendem bulhufas da área de conhecimento abordada no manuscrito. É o que eu chamo de adoção da autoridade da ciência. Como em muitos casos se usa isso de forma adequada, se referindo a uma vasta literatura científica confirmando esses resultados, outros se utilizam dessa autoridade para confirmar opiniões pessoais. Qual meu ponto? Que sejamos os mais claros possível, já que embora o que “queremos dizer” como cientistas é óbvio para nós, cientistas, nem sempre é o caso para quem não faz parte desse ecossistema.

Viva a ciência! :-)